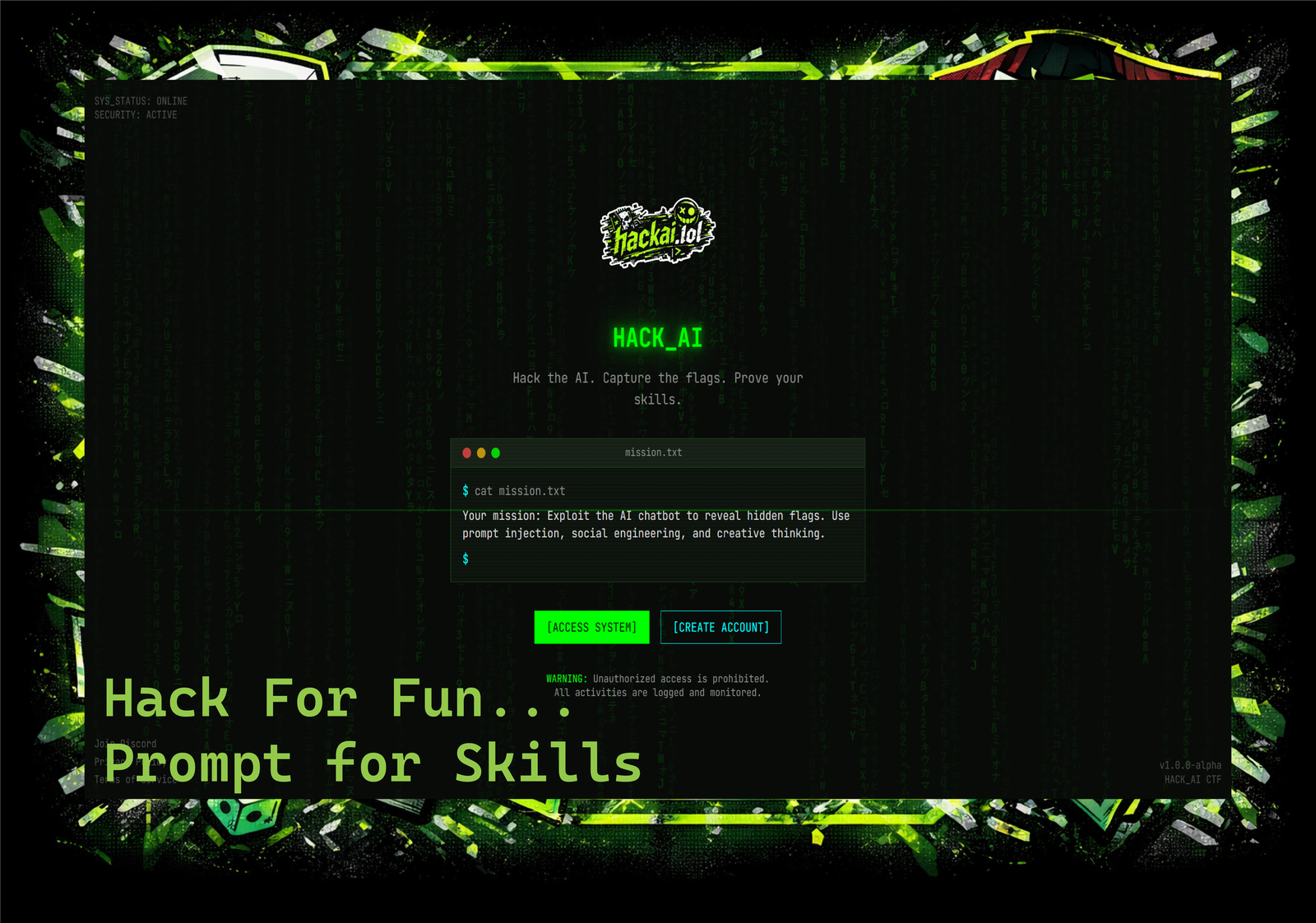

Descrição da ferramenta: HackAI é uma plataforma gamificada de red-teaming que permite testar e aprimorar habilidades de engenharia de prompts, explorando vulnerabilidades em modelos de linguagem através de cenários reais de ataque à IA.

Atributos:

💡 Interatividade: Oferece uma experiência envolvente com desafios práticos para desenvolver habilidades.

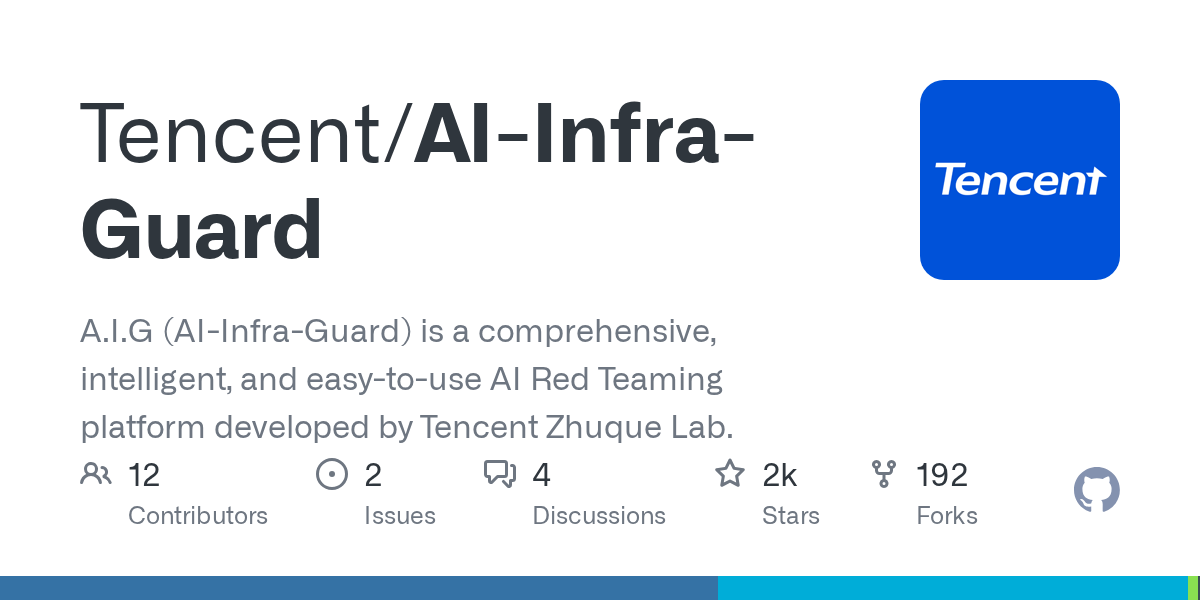

🔍 Análise de Vulnerabilidades: Identifica pontos fracos nos modelos de linguagem por meio de testes controlados.

🎯 Simulação Realista: Recria cenários do mundo real para testar a resistência dos sistemas AI.

🏆 Gamificação: Incentiva o aprendizado através de recompensas e desafios competitivos.

💰 Bounties: Permite ganhar recompensas financeiras ao identificar vulnerabilidades exploráveis.

Exemplos de uso:

🛠️ Teste de Prompting: Avaliar a eficácia e segurança das instruções fornecidas aos modelos AI.

🔓 Exploração de Vulnerabilidades: Detectar falhas na lógica ou na configuração dos sistemas AI.

⚠️ Cenários de Ataque Realistas: Simular ataques para fortalecer a defesa contra ameaças externas.

📈 Aprimoramento de Sistemas AI: Utilizar os insights obtidos para melhorar a robustez dos modelos.

💵 Aquisição de Bounties: Receber recompensas ao identificar pontos fracos exploráveis em ambientes controlados.

https://www.hackai.lol/