Descrição da ferramenta: InferiaLLM é um sistema operacional para execução de inferências de modelos de linguagem em larga escala, integrando gerenciamento de usuários, proxy de inferência, agendamento, roteamento e orquestração de recursos em uma única plataforma.

Atributos:

🛠️ Gerenciamento de usuários: Controla acessos e permissões dos usuários na plataforma.

🔄 Orquestração de recursos: Coordena a alocação eficiente de hardware para tarefas de inferência.

🚦 Política de roteamento: Define regras para direcionar requisições aos modelos adequados.

⚙️ Agendamento inteligente: Otimiza a distribuição das tarefas para desempenho máximo.

🌐 Proxy de inferência: Facilita o acesso às APIs dos modelos com alta disponibilidade.

Exemplos de uso:

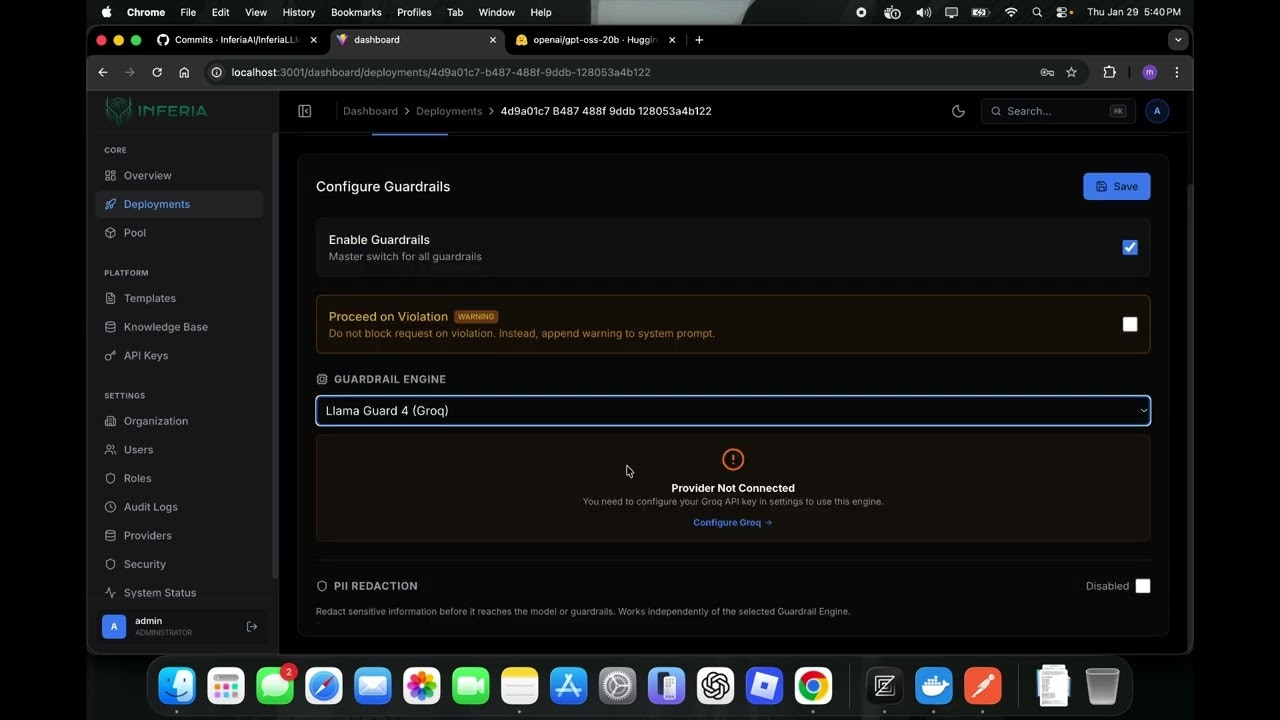

💻 Implantação interna de LLMs: Executar modelos localmente para garantir privacidade e controle.

📊 Acompanhamento do desempenho: Monitorar métricas e uso dos modelos em tempo real.

🔧 Ajuste na política de roteamento: Direcionar requisições específicas para diferentes versões do modelo.

🚀 Pico de demanda: Escalar automaticamente os recursos durante picos no uso do sistema.

🔒 Controle de acesso: Gerenciar permissões dos usuários que utilizam os modelos em produção.