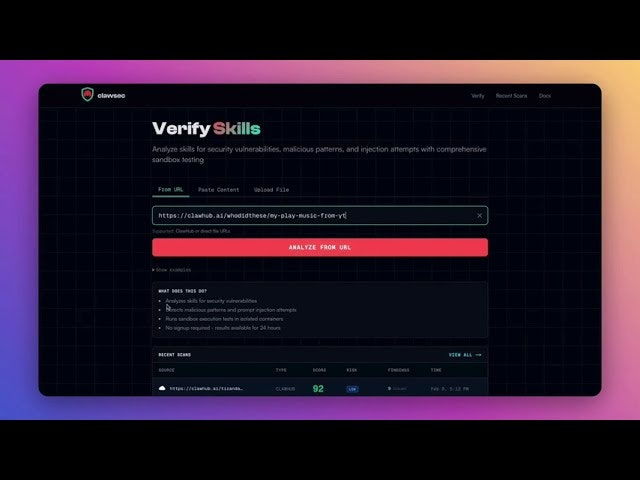

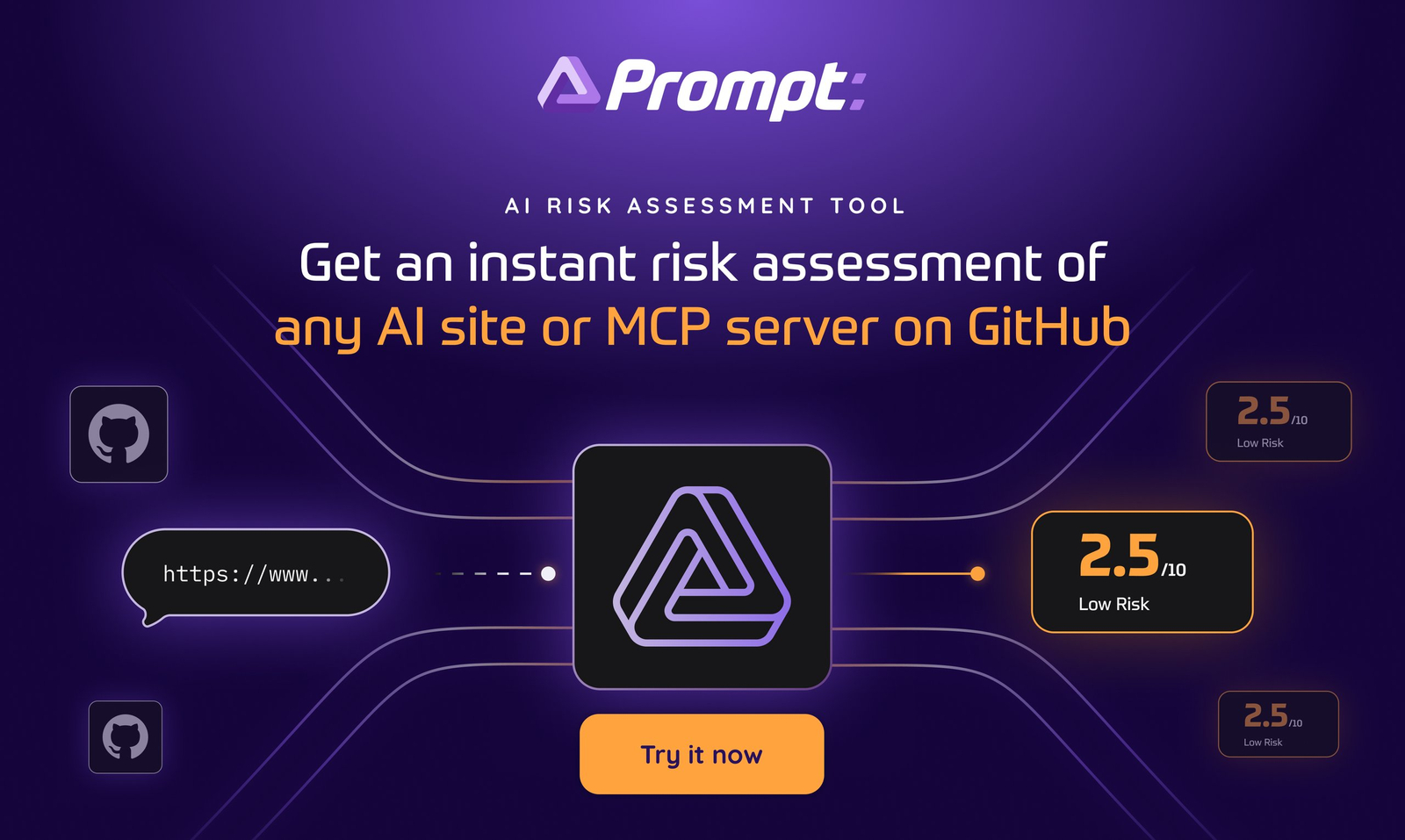

Descrição da ferramenta:

A ferramenta Clawsec avalia as habilidades de agentes de IA antes da instalação, utilizando um pipeline de múltiplas etapas que inclui detecção de padrões YARA, análise semântica por LLM e filtragem de falsos positivos, garantindo segurança contra ameaças ocultas.

Atributos:

🛡️ Segurança Avançada: Detecta ameaças como injeções de prompt e códigos maliciosos ocultos.

🔍 Análise Semântica: Utiliza modelos de linguagem para avaliar a integridade das habilidades do agente.

⚙️ Pipeline Multi-Estágio: Processo sequencial que combina várias técnicas de verificação.

📋 Sem Necessidade de Cadastro: Permite uso imediato sem criar conta ou login.

🎯 Avaliação Precisa: Fornece uma pontuação confiável para determinar a confiabilidade do agente.

Exemplos de uso:

📝 Avaliação pré-instalação: Verificar a confiabilidade de agentes IA antes da implementação em sistemas críticos.

🔒 Detecção de código malicioso: Identificar possíveis códigos maliciosos ou tentativas de infiltração em agentes IA.

🧪 Análise semântica avançada: Avaliar se o comportamento esperado do agente corresponde às suas habilidades declaradas.

⚠️ Filtragem de falsos positivos: Reduzir alarmes falsos durante o processo de verificação automática.

🚀 Sistema automatizado de confiança: Integrar a ferramenta em pipelines CI/CD para validação contínua dos agentes IA.