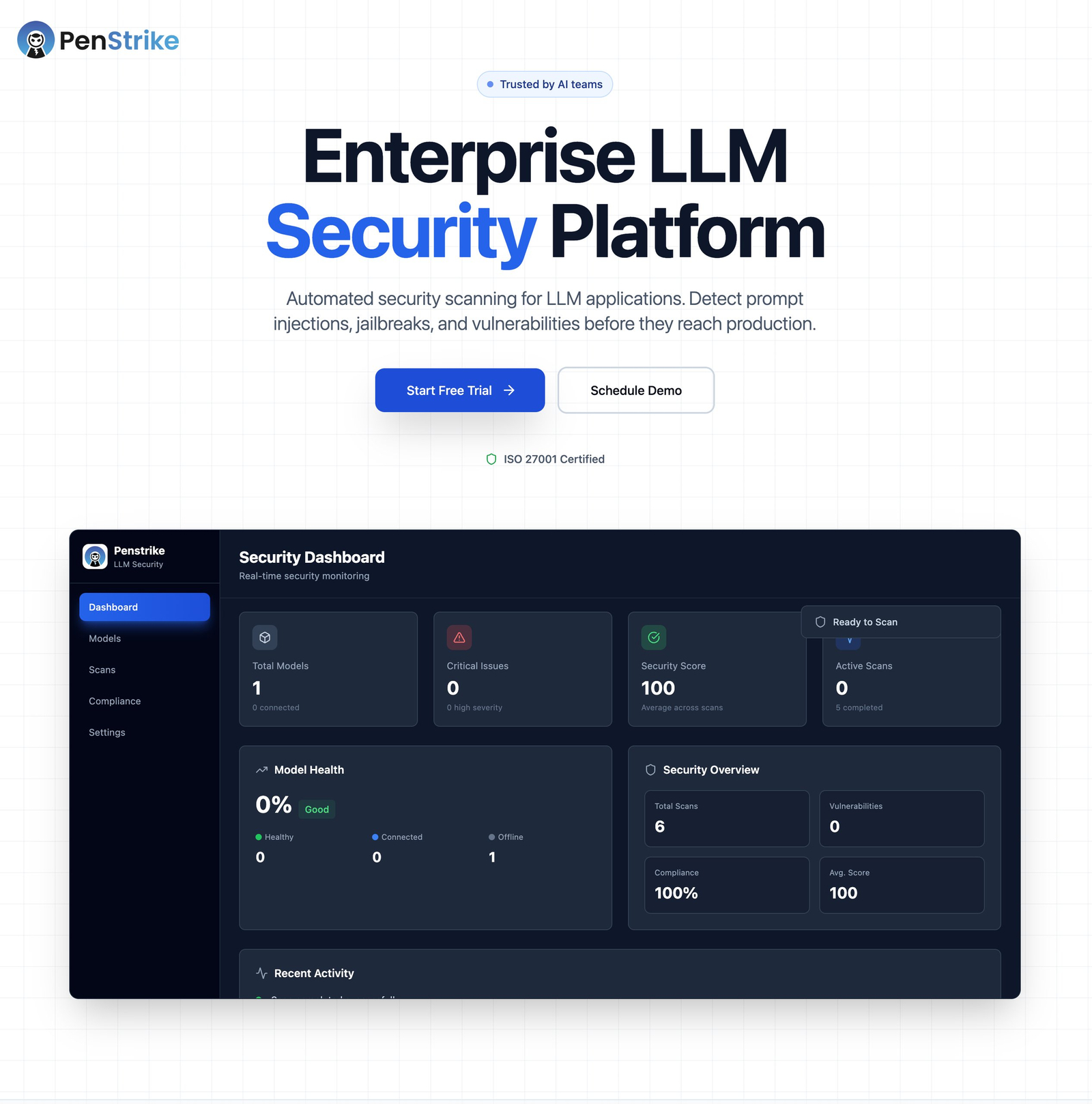

Descrição da ferramenta: SkillShield é uma plataforma que realiza varreduras em habilidades de IA, identificando vulnerabilidades críticas relacionadas à segurança, como roubo de credenciais, shells reversos e ataques de injeção de prompts.

Atributos:

🔍 Análise abrangente: Varre milhares de habilidades de IA para detectar vulnerabilidades potenciais.

🛡️ Segurança aprimorada: Identifica riscos críticos que podem comprometer a integridade dos agentes de IA.

⚠️ Relatórios detalhados: Fornece informações específicas sobre falhas encontradas nas habilidades escaneadas.

🚀 Implementação rápida: Permite ações rápidas para corrigir ou mitigar vulnerabilidades detectadas.

🌐 Diversidade de habilidades: Compatível com uma vasta gama de habilidades e agentes de IA utilizados no mercado.

Exemplos de uso:

📝 Avaliação de segurança pré-implantação: Verifica habilidades antes do uso em ambientes produtivos para evitar vulnerabilidades.

🔒 Auditoria periódica: Realiza inspeções regulares em habilidades existentes para manter a segurança atualizada.

🛠️ Correção automatizada: Auxilia na identificação e correção automática de problemas críticos detectados nas habilidades.

📊 Relatórios gerenciais: Gera relatórios detalhados para equipes técnicas e gerenciais acompanharem o status da segurança.

🌍 Análise global de riscos: Avalia as habilidades utilizadas em diferentes projetos ou plataformas, promovendo uma visão consolidada dos riscos.