Descrição da ferramenta: LLM VibeCheck & VibeFlowChat é uma aplicação Windows que monitora hardware, recomenda modelos Ollama compatíveis e permite troca rápida e comparação de modelos de linguagem localmente.

Atributos:

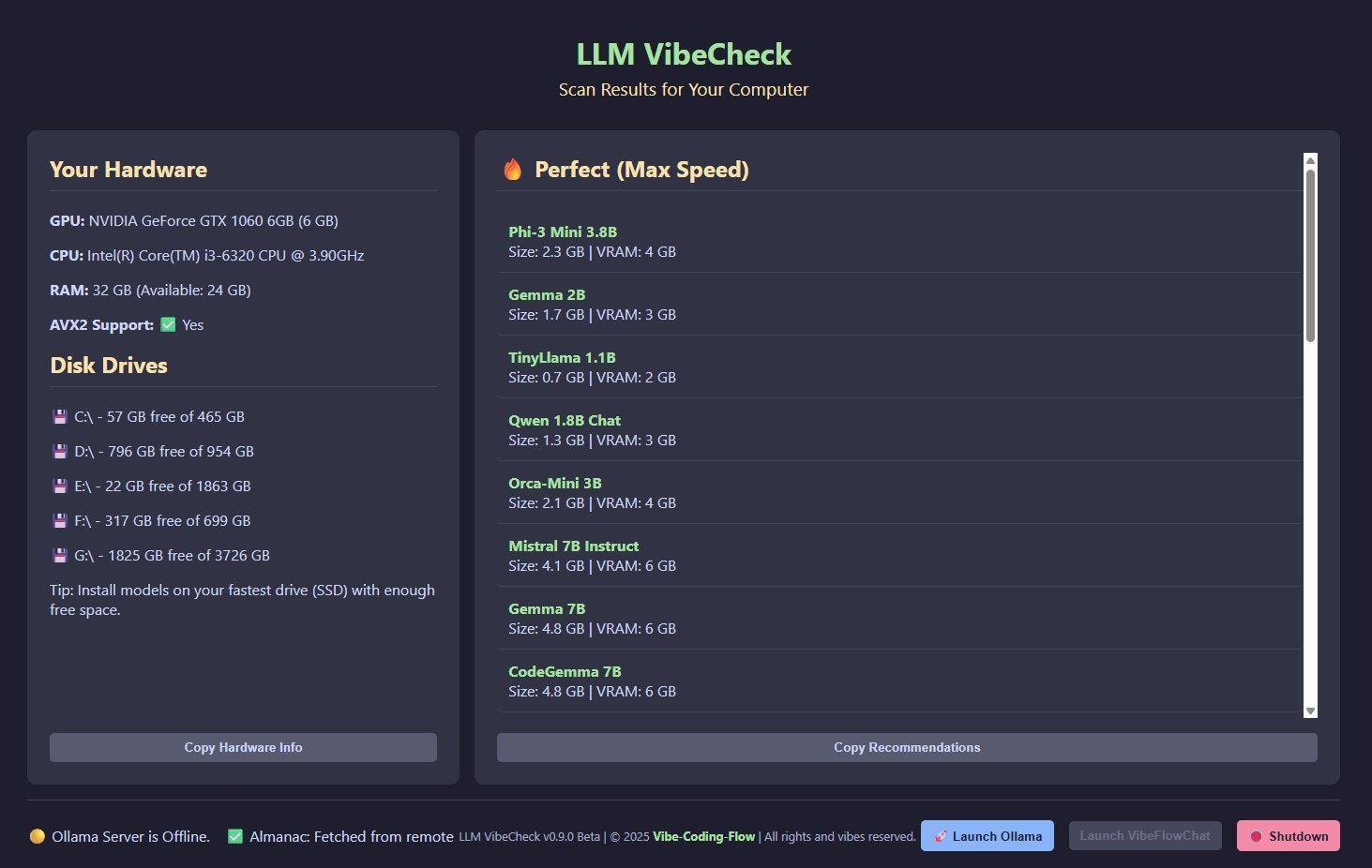

🖥️ Monitoramento de Hardware: Verifica GPU, VRAM e outros componentes essenciais para otimizar o desempenho dos LLMs.

🤖 Recomendação de Modelos: Sugere modelos Ollama compatíveis com a configuração do sistema.

💬 Chat Interativo: Permite troca instantânea entre diferentes modelos durante a conversa.

🔄 Troca Hot-Swap: Facilita a troca rápida de modelos para comparação side-by-side.

📊 Análise Comparativa: Oferece recursos para avaliar o desempenho dos modelos em tempo real.

Exemplos de uso:

🛠️ Configuração Inicial: Monitorar hardware e receber recomendações de modelos compatíveis ao instalar a ferramenta.

⚙️ Ajuste de Modelos: Trocar entre diferentes LLMs durante uma sessão para testar respostas específicas.

🔍 Análise de Desempenho: Comparar o desempenho de vários modelos lado a lado em tarefas similares.

💡 Tuning Rápido: Ajustar configurações e experimentar diferentes modelos sem reiniciar o sistema.

📝 Acompanhamento Técnico: Documentar resultados das comparações para otimizar futuras implementações.