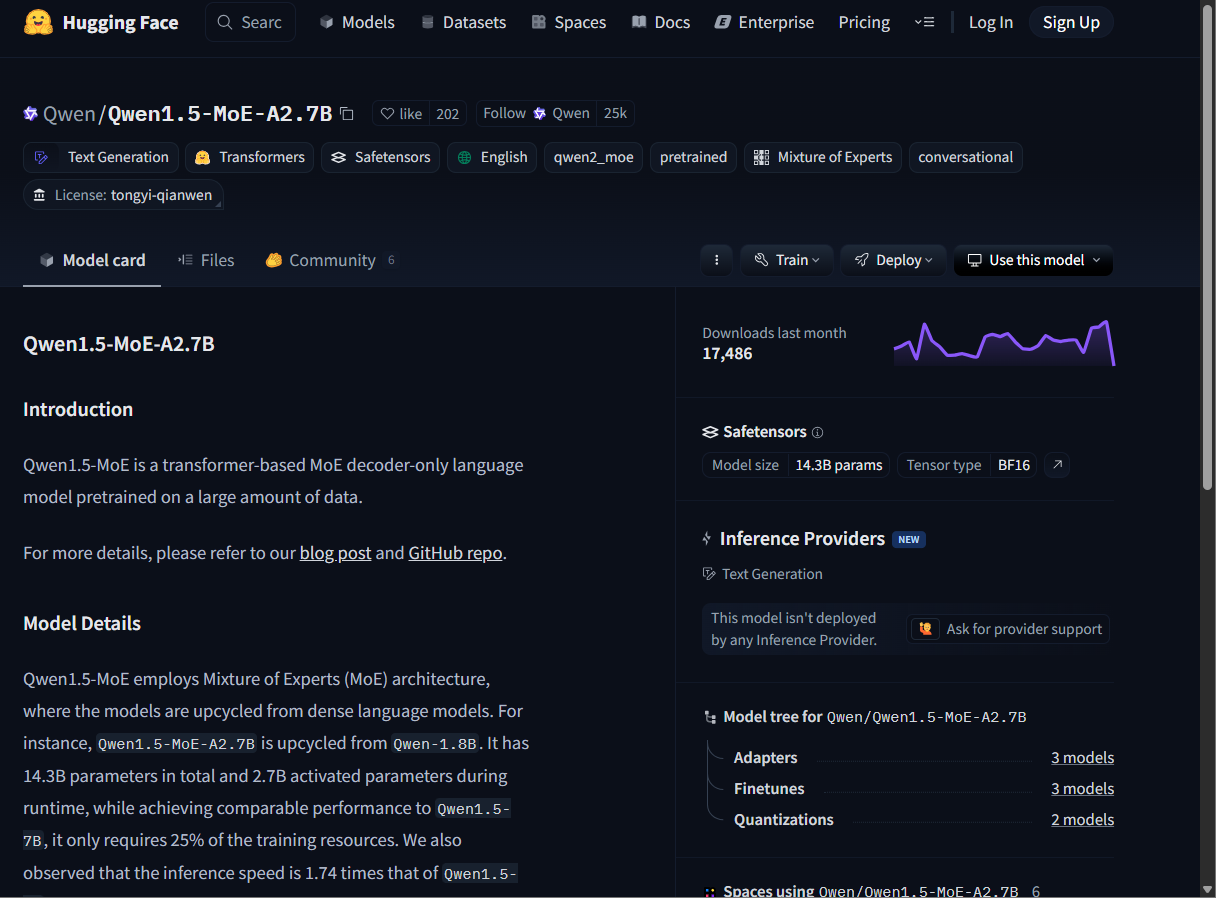

Qwen1.5-MoE-A2.7B é um modelo de linguagem baseado em arquitetura Mixture of Experts (MoE), com 14,3 bilhões de parâmetros totais e 2,7 bilhões ativados em tempo de execução. Oferece desempenho comparável ao Qwen1.5-7B, com menor custo computacional.

Atributos

🧠 Arquitetura Mixture of Experts (MoE)

Ativa apenas partes do modelo por vez, otimizando recursos durante a inferência.

⚙️ Eficiência Computacional

Reduz o uso de recursos de treinamento para 25% em comparação com modelos equivalentes.

🚀 Alta Velocidade de Inferência

É 1,74 vezes mais rápido que o Qwen1.5-7B em tarefas de geração de texto.

🔄 Pré-treinamento Adaptável

Indicado para ajustes posteriores como SFT, RLHF ou pretraining contínuo.

📦 Integração com Hugging Face Transformers

Disponível diretamente na biblioteca Transformers via instalação do repositório atualizado.

📉 Versão Upcycled de Qwen-1.8B

Baseado em modelo denso pré-existente, com arquitetura atualizada para MoE.

Exemplos de uso

📚 Pesquisa Acadêmica

Aplicado em estudos sobre otimização de modelos de linguagem de grande porte.

🛠️ Desenvolvedores de Modelos LLM

Utilizado como base para ajuste fino (finetuning) e experimentações com técnicas como RLHF.

📊 Benchmarking e Competição

Empregado em testes comparativos de desempenho e eficiência entre modelos.

🏗️ Infraestrutura de IA

Implementado em ambientes que demandam alta velocidade de inferência com menor custo computacional.

🧪 Projetos Experimentais com MoE

Ideal para laboratórios e projetos exploratórios sobre arquitetura Mixture of Experts.