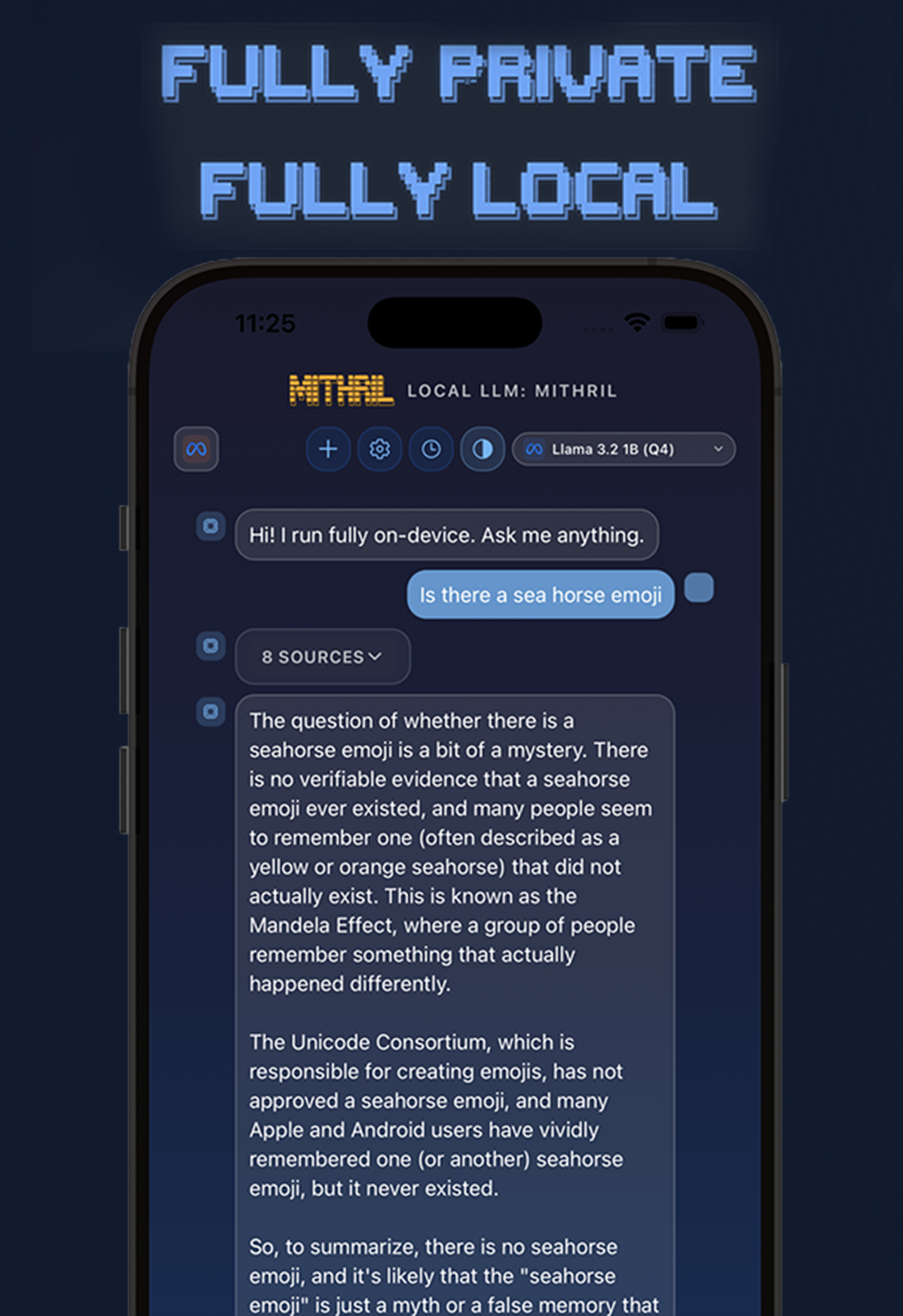

Descrição da ferramenta: O Local LLM: MITHRIL é uma suíte que permite executar grandes modelos de linguagem inteiramente no dispositivo, garantindo privacidade total e sem dependência de conexão com a nuvem ou transmissão de dados.

Atributos:

🛡️ Privacidade: Executa modelos localmente, assegurando que os dados do usuário permaneçam confidenciais.

⚙️ Open-source: Baseado em tecnologias open-source como llama.cpp e ExecuTorch, promovendo transparência e customização.

🚀 Desempenho: Oferece processamento eficiente de modelos de linguagem avançados diretamente no dispositivo.

📱 Offline: Funciona totalmente offline, sem necessidade de conexão à internet para operação.

🔧 Compatibilidade: Compatível com dispositivos móveis, facilitando o uso em smartphones e tablets.

Exemplos de uso:

💬 Assistente pessoal: Utilizar o modelo para responder perguntas ou auxiliar em tarefas diárias sem conexão à internet.

📝 Análise de textos: Processar documentos ou textos longos localmente para extração de informações relevantes.

🤖 Chatbots privados: Desenvolver chatbots internos para empresas ou projetos pessoais com total segurança dos dados.

📚 E-learning: Criar aplicações educativas que utilizam IA para interagir com estudantes offline.

🧠 Pesquisas acadêmicas: Realizar análises linguísticas ou experimentos com modelos treinados localmente, preservando a confidencialidade dos dados.