Descrição da ferramenta: O LLM Leaderboard App permite comparar modelos de IA como ChatGPT, Claude e Gemini por desempenho em raciocínio, codificação, matemática, criatividade, preço e velocidade, com visualizações claras e filtros avançados para facilitar a escolha informada.

Atributos:

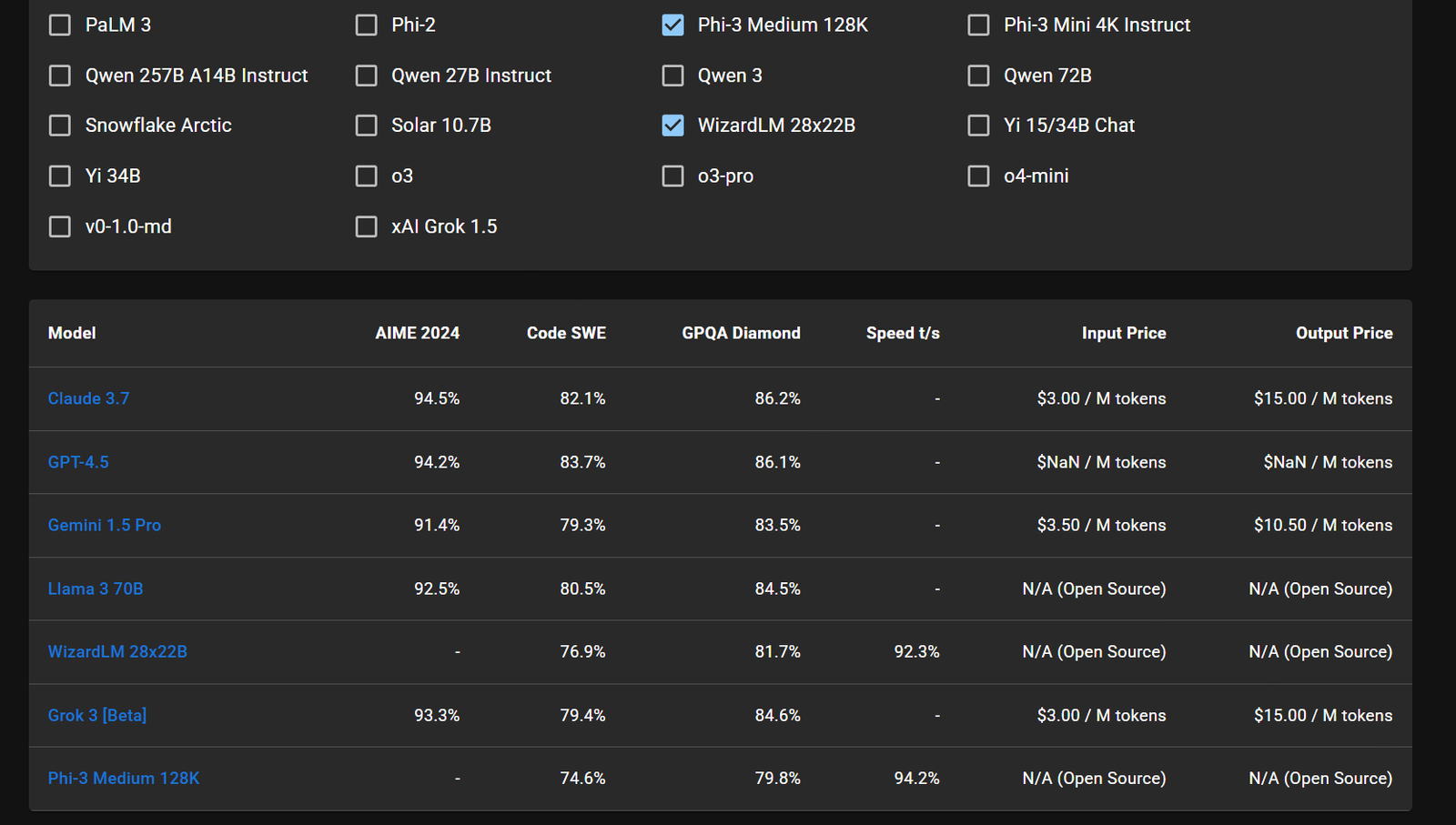

🔍 Filtros Avançados: Permitem refinar buscas por critérios específicos de desempenho e características dos modelos.

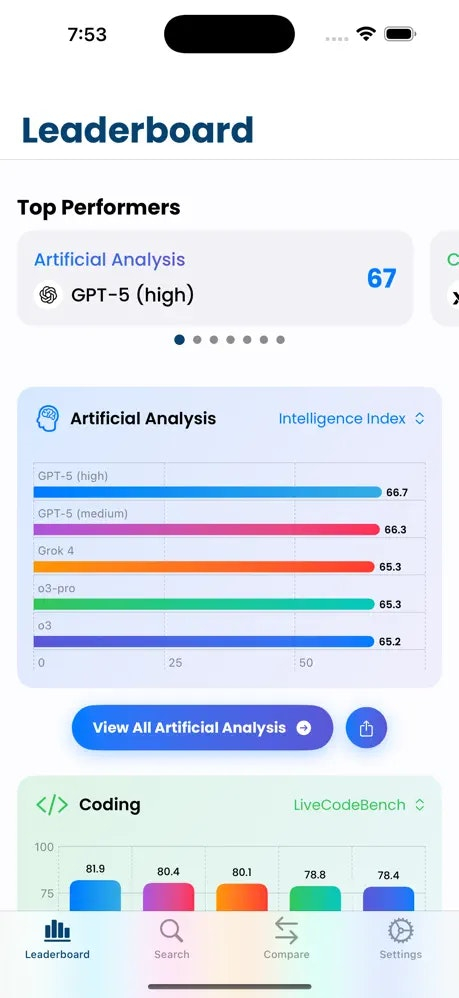

📊 Visualização de Leaderboards: Apresenta rankings em gráficos intuitivos para comparação rápida entre diferentes IAs.

⚡ Atualizações Regulares: Dados atualizados periodicamente até 2025, garantindo informações recentes e precisas.

💡 Análise Multidimensional: Avalia múltiplos atributos como velocidade, custo e capacidade de raciocínio simultaneamente.

🔎 Acesso Sem Anúncios: Interface limpa sem publicidade, focada na apresentação objetiva dos dados.

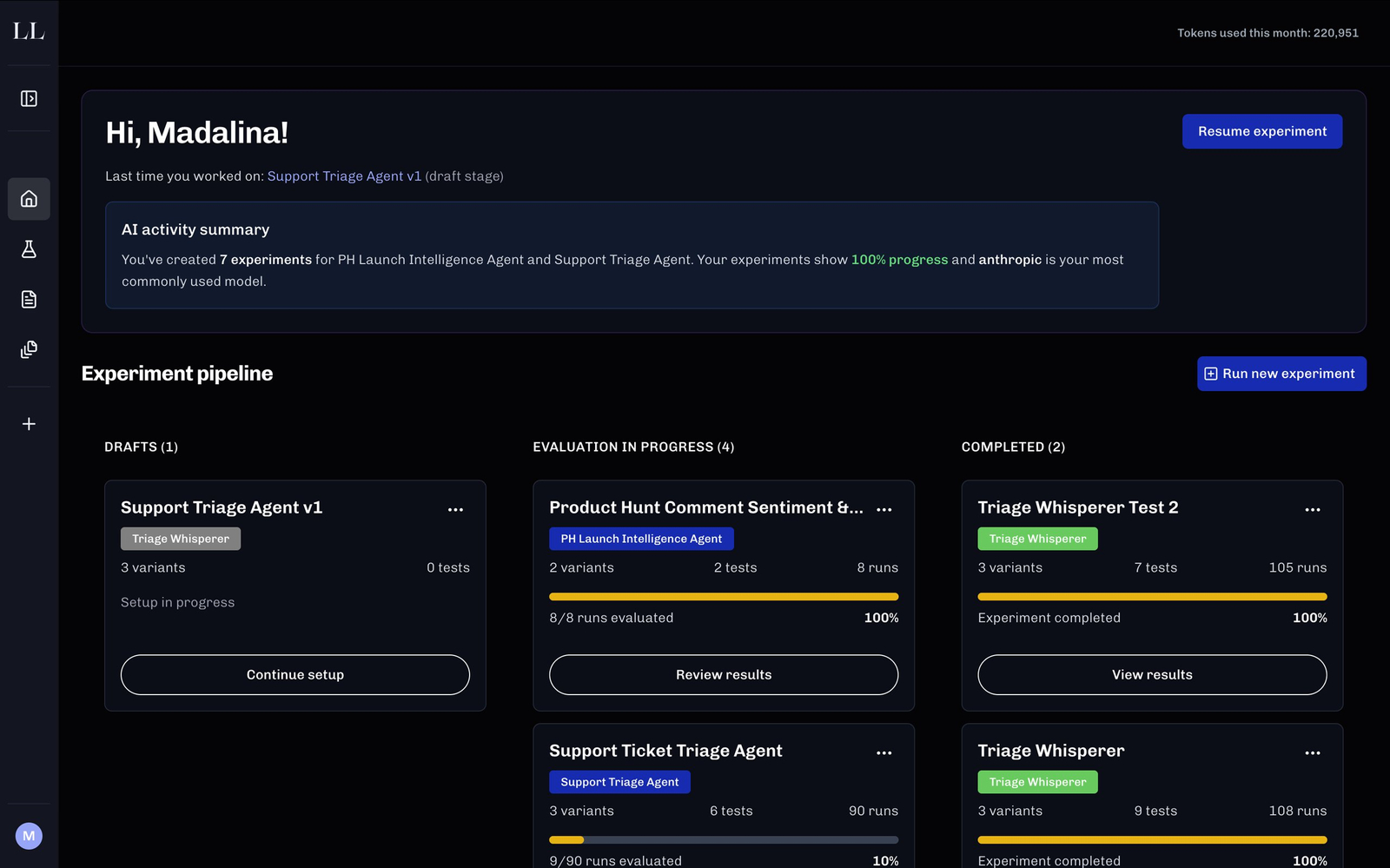

Exemplos de uso:

🧠 Avaliação de Modelos para Pesquisa Acadêmica: Comparar IA para selecionar a mais adequada às necessidades acadêmicas ou científicas.

💻 Escolha de IA para Desenvolvimento de Software: Identificar o modelo com melhor desempenho em codificação e velocidade.

📈 Análise de Mercado de IA: Monitorar tendências e melhorias nos principais modelos disponíveis no mercado.

📝 Avaliação de Criatividade Artificial: Testar diferentes IAs quanto à geração de conteúdo criativo ou inovador.

💰 Análise de Custo-Benefício: Comparar preços e eficiência dos modelos para otimizar investimentos em IA.