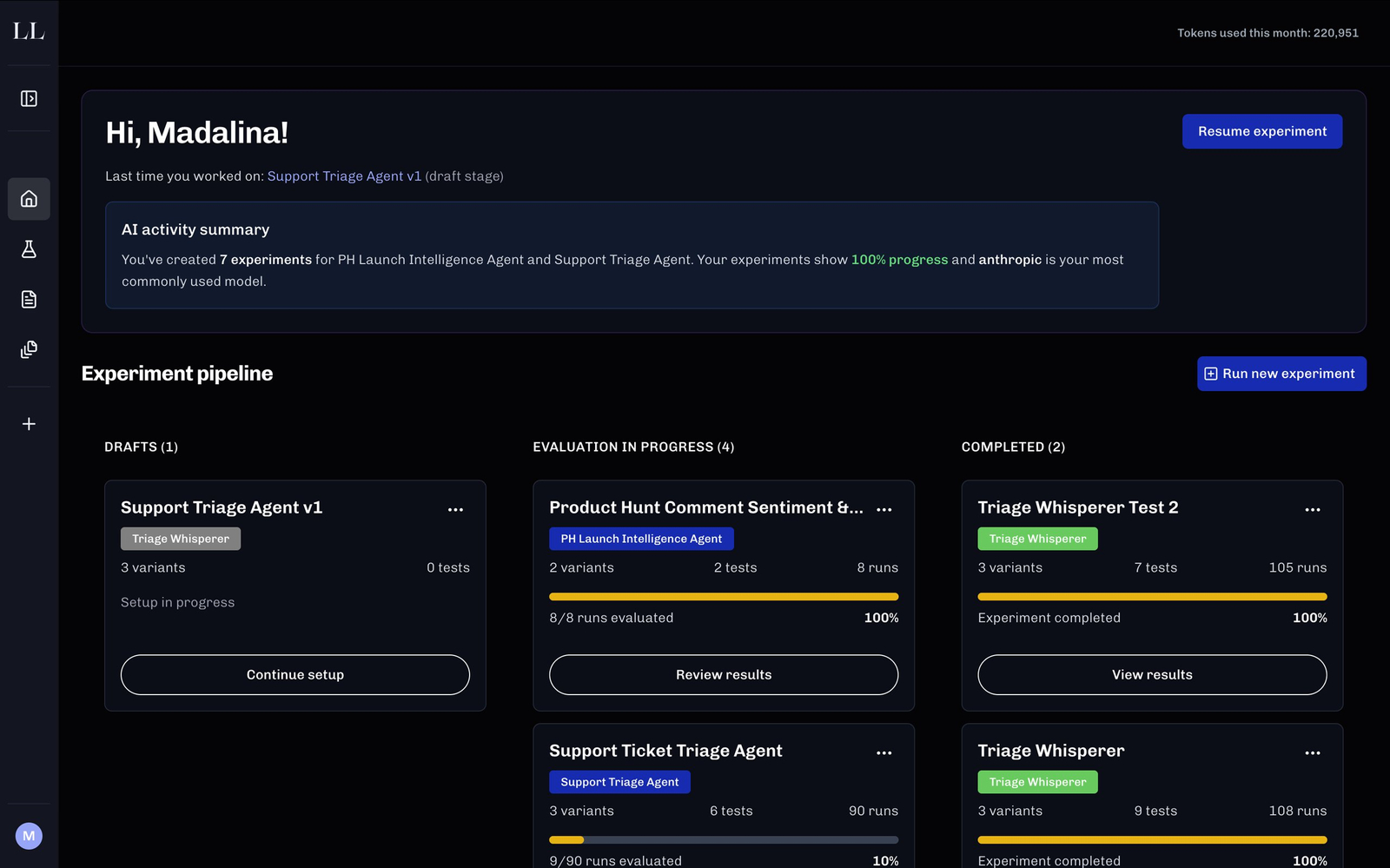

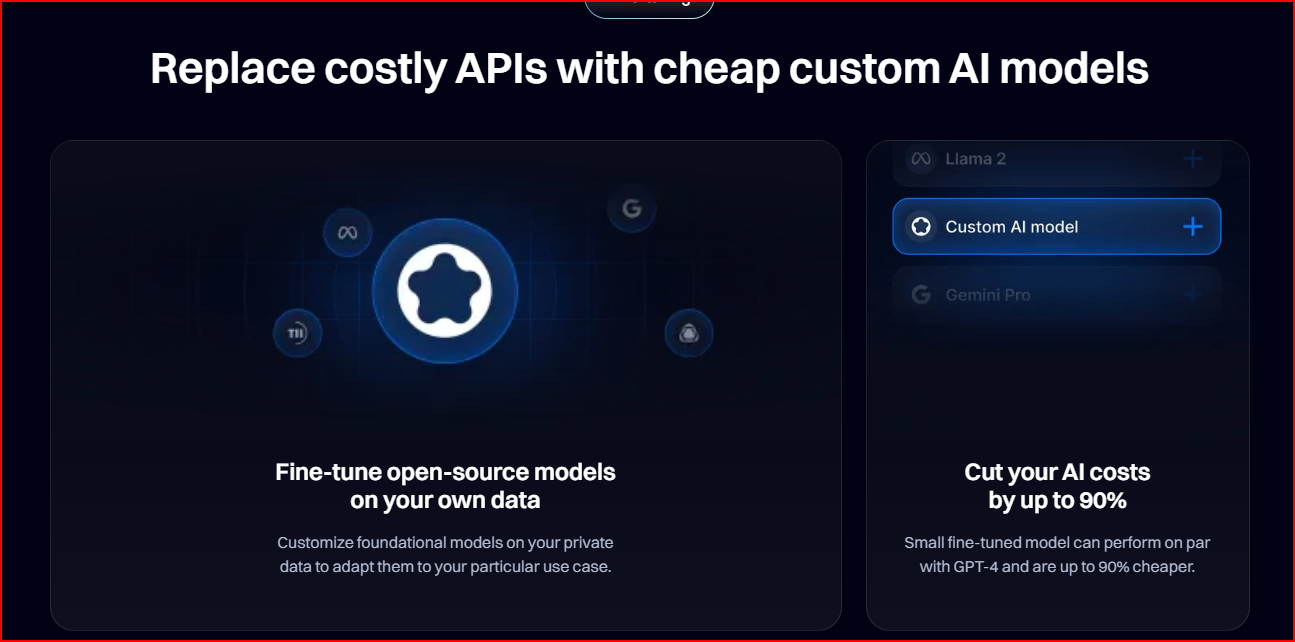

Descrição da ferramenta: Lovelaice é uma plataforma que permite testar, avaliar e otimizar prompts em diversos modelos de IA, como OpenAI, Claude e Gemini, facilitando a comparação e implementação de melhorias sem necessidade de conhecimento técnico.

Atributos:

🧪 Testes Multimodelo: Permite experimentar prompts em diferentes plataformas de IA para identificar o melhor desempenho.

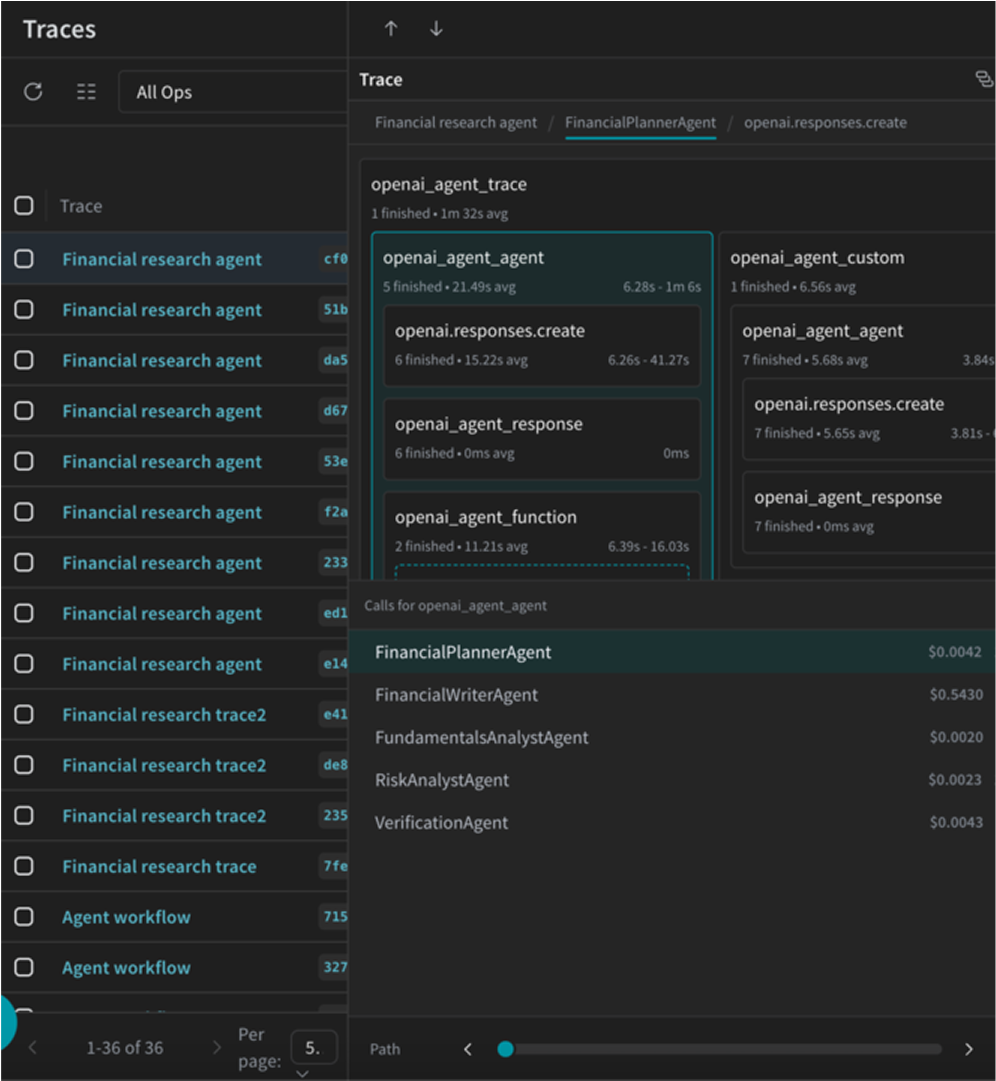

📊 Avaliação de Resultados: Oferece métricas e rankings claros para analisar a eficácia dos prompts.

⚙️ Otimização de Prompts: Sugere melhorias para maximizar a eficiência das respostas geradas.

🔄 Comparação Side-by-Side: Facilita a análise simultânea de múltiplos modelos em uma única interface.

🚀 Deploy via API: Permite implementar a versão otimizada do prompt diretamente por API, sem necessidade de conhecimentos técnicos avançados.

Exemplos de uso:

💡 Criadores de conteúdo: Testar diferentes prompts para gerar textos mais relevantes e criativos.

🔍 Avaliação de modelos AI: Comparar o desempenho do GPT-4 com outros modelos como Claude ou Gemini.

🛠️ Otimização de prompts empresariais: Refinar comandos utilizados em chatbots corporativos para melhorar o atendimento ao cliente.

📈 Análise de resultados: Monitorar as respostas dos modelos e ajustar os prompts conforme necessário para obter melhores resultados.

🚀 Implementação rápida via API: Deployar a versão final do prompt na aplicação sem complexidade técnica adicional.