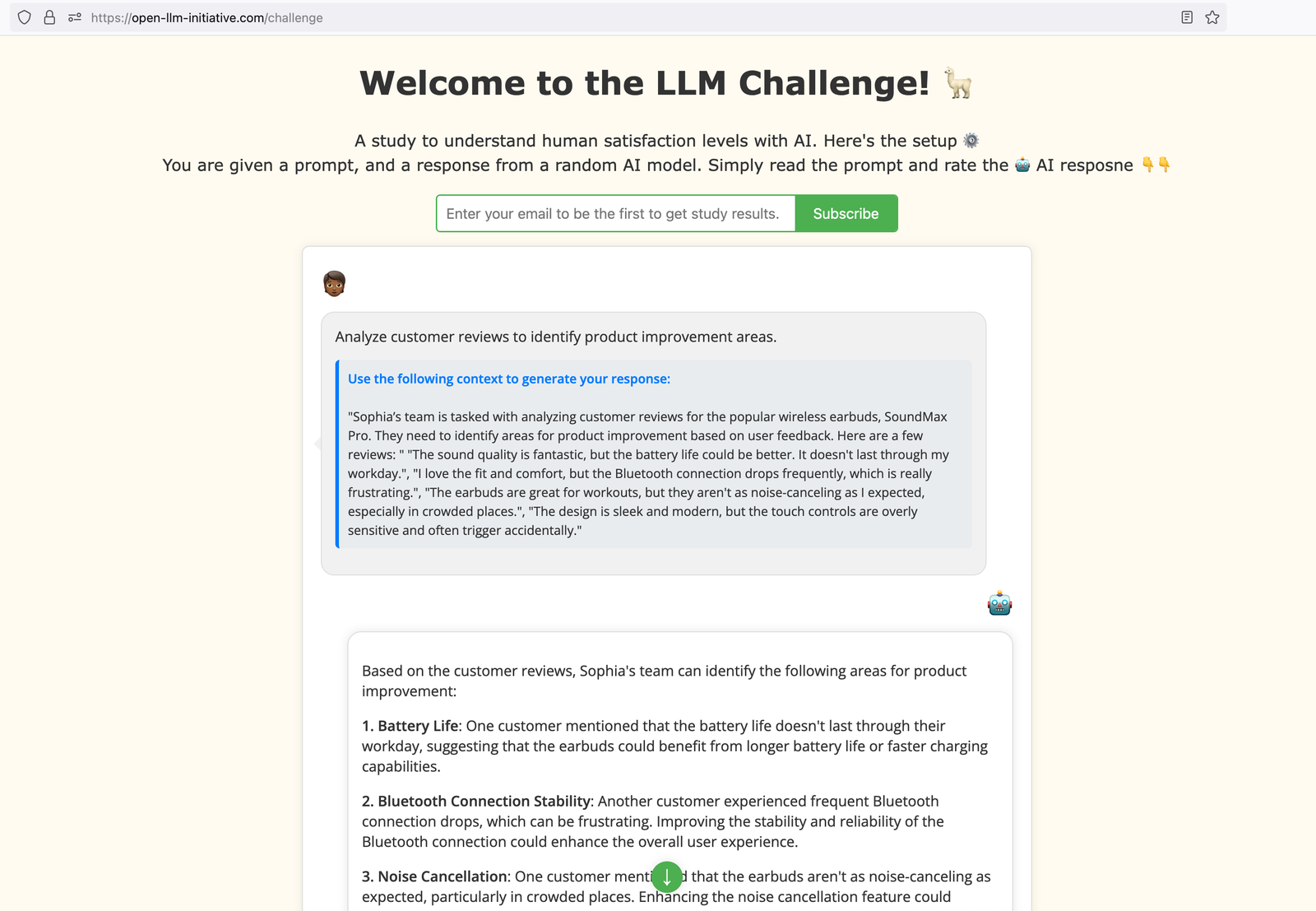

Descrição da ferramenta: O desafio LLM fornece uma estrutura para avaliar modelos de linguagem de grande porte (LLMs) com foco na satisfação do usuário final, facilitando a compreensão dos desenvolvedores e tomadores de decisão sobre como esses modelos se comportam em cenários práticos.

Atributos:

- 🔍 Avaliação Focada no Usuário: Mede a satisfação dos usuários finais com os resultados gerados pelos LLMs.

- 📊 Diversidade de Benchmarks: Oferece um conjunto variado de benchmarks para testar diferentes aspectos dos LLMs.

- ⚙️ Facilidade de Implementação: Proporciona uma interface amigável para que desenvolvedores integrem as avaliações em seus fluxos de trabalho.

- 📈 Análise Comparativa: Permite comparar o desempenho entre diferentes LLMs em um mesmo contexto.

- 🛠️ Documentação Abrangente: Fornece guias e exemplos detalhados para facilitar a compreensão e uso da ferramenta.

Exemplos de uso:

- 📝 Avaliação de Chatbots: Utilizar o desafio LLM para medir a eficácia e satisfação dos usuários em interações com chatbots baseados em LLMs.

- 📚 Análise de Respostas Automáticas: Aplicar benchmarks para avaliar a qualidade das respostas geradas por sistemas automáticos em serviços ao cliente.

- 🔧 Aprimoramento de Assistentes Virtuais: Testar diferentes versões de assistentes virtuais utilizando métricas do desafio LLM para identificar melhorias necessárias.

- 💬 Edição Colaborativa em Documentos: Avaliar como os LLMs contribuem na co-criação e edição colaborativa, medindo a satisfação dos usuários envolvidos.

- 🌐 Análise Multilíngue: Usar o desafio LLM para comparar o desempenho de modelos multilíngues, focando na experiência do usuário final em diferentes idiomas.